Pubblichiamo di seguito il Messaggio del Santo Padre per la LX Giornata Mondiale delle Comunicazioni Sociali sul tema: Custodire voci e volti umani.

Pubblichiamo di seguito il Messaggio del Santo Padre per la LX Giornata Mondiale delle Comunicazioni Sociali sul tema: Custodire voci e volti umani.

Messaggio del Santo Padre

Custodire voci e volti umani

Cari fratelli e sorelle!

Il volto e la voce sono tratti unici, distintivi, di ogni persona; manifestano la propria irripetibile identità e sono l’elemento costitutivo di ogni incontro. Gli antichi lo sapevano bene. Così, per definire la persona umana gli antichi greci hanno utilizzato la parola “volto” (prósōpon) che etimologicamente indica ciò che sta di fronte allo sguardo, il luogo della presenza e della relazione. Il termine latino persona (da per-sonare) include invece il suono: non un suono qualsiasi, ma la voce inconfondibile di qualcuno.

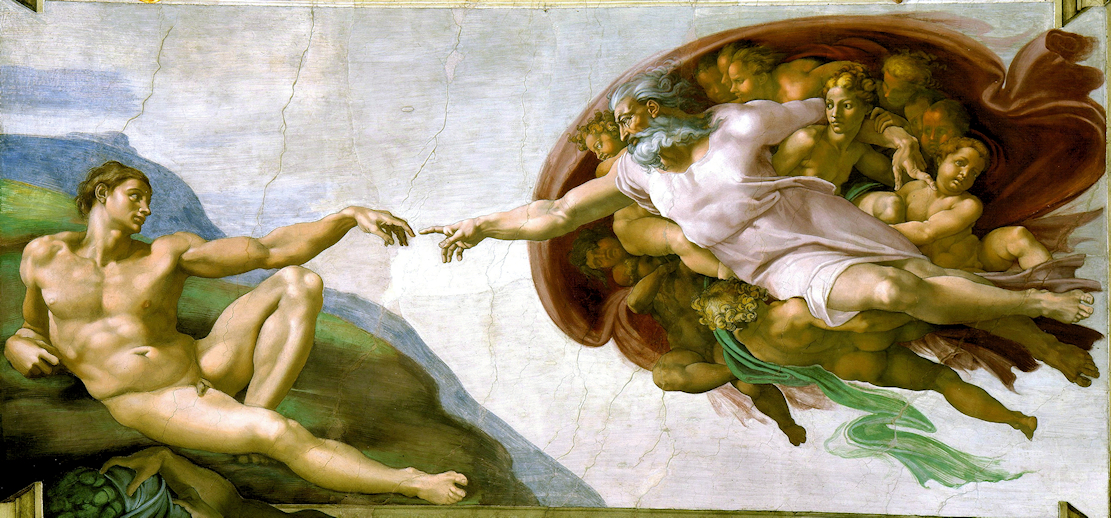

Volto e voce sono sacri. Ci sono stati donati da Dio che ci ha creati a sua immagine e somiglianza chiamandoci alla vita con la Parola che Egli stesso ci ha rivolto; Parola prima risuonata attraverso i secoli nelle voci dei profeti, quindi divenuta carne nella pienezza dei tempi. Questa Parola – questa comunicazione che Dio fa di sé stesso – l’abbiamo anche potuta ascoltare e vedere direttamente (cfr 1 Gv 1,1-3), perché si è fatta conoscere nella voce e nel Volto di Gesù, Figlio di Dio.

Fin dal momento della sua creazione Dio ha voluto l’uomo quale proprio interlocutore e, come dice San Gregorio di Nissa,[1] ha impresso sul suo volto un riflesso dell’amore divino, affinché possa vivere pienamente la propria umanità mediante l’amore. Custodire volti e voci umane significa perciò custodire questo sigillo, questo riflesso indelebile dell’amore di Dio. Non siamo una specie fatta di algoritmi biochimici, definiti in anticipo. Ciascuno di noi ha una vocazione insostituibile e inimitabile che emerge dalla vita e che si manifesta proprio nella comunicazione con gli altri.

La tecnologia digitale, se veniamo meno a questa custodia, rischia invece di modificare radicalmente alcuni dei pilastri fondamentali della civiltà umana, che a volte diamo per scontati. Simulando voci e volti umani, sapienza e conoscenza, consapevolezza e responsabilità, empatia e amicizia, i sistemi conosciuti come intelligenza artificiale non solo interferiscono negli ecosistemi informativi, ma invadono anche il livello più profondo della comunicazione, quello del rapporto tra persone umane.

La sfida pertanto non è tecnologica, ma antropologica. Custodire i volti e le voci significa in ultima istanza custodire noi stessi. Accogliere con coraggio, determinazione e discernimento le opportunità offerte dalla tecnologia digitale e dall’intelligenza artificiale non vuol dire nascondere a noi stessi i punti critici, le opacità, i rischi.

Non rinunciare al proprio pensiero

Ci sono da tempo molteplici evidenze del fatto che algoritmi progettati per massimizzare il coinvolgimento sui social media – redditizio per le piattaforme – premiano emozioni rapide e penalizzano invece espressioni umane più bisognose di tempo come lo sforzo di comprendere e la riflessione. Chiudendo gruppi di persone in bolle di facile consenso e facile indignazione, questi algoritmi indeboliscono la capacità di ascolto e di pensiero critico e aumentano la polarizzazione sociale.

A questo si è aggiunto poi un affidamento ingenuamente acritico all’intelligenza artificiale come “amica” onnisciente, dispensatrice di ogni informazione, archivio di ogni memoria, “oracolo” di ogni consiglio. Tutto ciò può logorare ulteriormente la nostra capacità di pensare in modo analitico e creativo, di comprendere i significati, di distinguere tra sintassi e semantica.

Sebbene l’IA possa fornire supporto e assistenza nella gestione di compiti comunicativi, sottrarsi allo sforzo del proprio pensiero, accontentandoci di una compilazione statistica artificiale, rischia a lungo andare di erodere le nostre capacità cognitive, emotive e comunicative.

Negli ultimi anni i sistemi di intelligenza artificiale stanno assumendo sempre di più anche il controllo della produzione di testi, musica e video. Gran parte dell’industria creativa umana rischia così di essere smantellata e sostituita con l’etichetta “Powered by AI”, trasformando le persone in meri consumatori passivi di pensieri non pensati, di prodotti anonimi, senza paternità, senza amore. Mentre i capolavori del genio umano nel campo di musica, arte e letteratura vengono ridotti a un mero campo di addestramento delle macchine.

La questione che ci sta a cuore, tuttavia, non è cosa riesce o riuscirà a fare la macchina, ma cosa possiamo e potremo fare noi, crescendo in umanità e conoscenza, con un uso sapiente di strumenti così potenti a nostro servizio. Da sempre l’uomo è tentato di appropriarsi del frutto della conoscenza senza la fatica del coinvolgimento, della ricerca e della responsabilità personale. Rinunciare al processo creativo e cedere alle macchine le proprie funzioni mentali e la propria immaginazione significa tuttavia seppellire i talenti che abbiamo ricevuto al fine di crescere come persone in relazione a Dio e agli altri. Significa nascondere il nostro volto, e silenziare la nostra voce.

Essere o fingere: simulazione delle relazioni e della realtà

Mentre scorriamo i nostri flussi di informazioni (feed), diventa così sempre più difficile capire se stiamo interagendo con altri esseri umani o con dei “bot” o dei “virtual influencers”. Gli interventi non trasparenti di questi agenti automatizzati influenzano i dibattiti pubblici e le scelte delle persone. Soprattutto i chatbot basati su grandi modelli linguistici (LLM) si stanno rivelando sorprendentemente efficaci nella persuasione occulta, attraverso una continua ottimizzazione dell’interazione personalizzata. La struttura dialogica e adattiva, mimetica, di questi modelli linguistici è capace di imitare i sentimenti umani e simulare così una relazione. Questa antropomorfizzazione, che può risultare persino divertente, è allo stesso tempo ingannevole, soprattutto per le persone più vulnerabili. Perché i chatbot resi eccessivamente “affettuosi”, oltre che sempre presenti e disponibili, possono diventare architetti nascosti dei nostri stati emotivi e in questo modo invadere e occupare la sfera dell’intimità delle persone.

La tecnologia che sfrutta il nostro bisogno di relazione può non solo avere conseguenze dolorose sul destino dei singoli, ma può anche ledere il tessuto sociale, culturale e politico delle società. Ciò avviene quando sostituiamo alle relazioni con gli altri quelle con IA addestrate a catalogare i nostri pensieri e quindi a costruirci intorno un mondo di specchi, dove ogni cosa è fatta “a nostra immagine e somiglianza”. In questo modo ci lasciamo derubare della possibilità di incontrare l’altro, che è sempre diverso da noi, e con il quale possiamo e dobbiamo imparare a confrontarci. Senza l’accoglienza dell’alterità non può esserci né relazione né amicizia.

Un’altra grande sfida che questi sistemi emergenti pongono è quella della distorsione (in inglese bias), che porta ad acquisire e a trasmettere una percezione alterata della realtà. I modelli di IA sono plasmati dalla visione del mondo di chi li costruisce e possono a loro volta imporre modi di pensare replicando gli stereotipi e i pregiudizi presenti nei dati a cui attingono. La mancanza di trasparenza nella progettazione degli algoritmi, insieme alla non adeguata rappresentanza sociale dei dati, tendono a farci rimanere intrappolati in reti che manipolano i nostri pensieri e perpetuano e approfondiscono le disuguaglianze e le ingiustizie sociali esistenti.

Il rischio è grande. Il potere della simulazione è tale che l’IA può anche illuderci con la fabbricazione di “realtà” parallele, appropriandosi dei nostri volti e delle nostre voci. Siamo immersi in una multidimensionalità, dove sta diventando sempre più difficile distinguere la realtà dalla finzione.

A ciò si aggiunge il problema della mancata accuratezza. Sistemi che spacciano una probabilità statistica per conoscenza stanno in realtà offrendoci al massimo delle approssimazioni alla verità, che a volte sono vere e proprie “allucinazioni”. Una mancata verifica delle fonti, insieme alla crisi del giornalismo sul campo che comporta un continuo lavoro di raccolta e verifica di informazioni svolte nei luoghi dove gli eventi accadono, può favorire un terreno ancora più fertile per la disinformazione, provocando un crescente senso di sfiducia, smarrimento e insicurezza.

Una possibile alleanza

Dietro questa enorme forza invisibile che ci coinvolge tutti, c’è solo una manciata di aziende, quelle i cui fondatori sono stati recentemente presentati come creatori della “persona dell’anno 2025”, ovvero gli architetti dell’intelligenza artificiale. Ciò determina una preoccupazione importante riguardo al controllo oligopolistico dei sistemi algoritmici e di intelligenza artificiale in grado di orientare sottilmente i comportamenti, e persino riscrivere la storia umana – compresa la storia della Chiesa – spesso senza che ce ne si possa rendere realmente conto.

La sfida che ci aspetta non sta nel fermare l’innovazione digitale, ma nel guidarla, nell’essere consapevoli del suo carattere ambivalente.Sta a ognuno di noi alzare la voce in difesa delle persone umane, affinché questi strumenti possano veramente essere da noi integrati come alleati.

Questa alleanza è possibile, ma ha bisogno di fondarsi su tre pilastri: responsabilità, cooperazione e educazione.

Innanzitutto la responsabilità. Essa può essere declinata, a seconda dei ruoli, come onestà, trasparenza, coraggio, capacità di visione, dovere di condividere la conoscenza, diritto a essere informati. Ma in generale nessuno può sottrarsi alla propria responsabilità di fronte al futuro che stiamo costruendo.

Per chi è al vertice delle piattaforme online ciò significa assicurarsi che le proprie strategie aziendali non siano guidate dall’unico criterio della massimizzazione del profitto, ma anche da una visione lungimirante che tenga conto del bene comune, allo stesso modo in cui ognuno di essi ha a cuore il bene dei propri figli.

Ai creatori e agli sviluppatori di modelli di IA è chiesta trasparenza e responsabilità sociale riguardo ai principi di progettazione e ai sistemi di moderazione alla base dei loro algoritmi e dei modelli sviluppati, in modo da favorire un consenso informato da parte degli utenti.

La stessa responsabilità è chiesta anche ai legislatori nazionali e ai regolatori sovranazionali, ai quali compete di vigilare sul rispetto della dignità umana. Una regolamentazione adeguata può tutelare le persone da un legame emotivo con i chatbot e contenere la diffusione di contenuti falsi, manipolativi o fuorvianti, preservando l’integrità dell’informazione rispetto a una sua simulazione ingannevole.

Le imprese dei media e della comunicazione non possono a loro volta permettere che algoritmi orientati a vincere a ogni costo la battaglia per qualche secondo di attenzione in più prevalgano sulla fedeltà ai loro valori professionali, volti alla ricerca della verità. La fiducia del pubblico si conquista con l’accuratezza, con la trasparenza, non con la rincorsa a un coinvolgimento qualsiasi. I contenuti generati o manipolati dall’IA vanno segnalati e distinti in modo chiaro dai contenuti creati dalle persone. Va tutelata la paternità e la proprietà sovrana dell’operato dei giornalisti e degli altri creatori di contenuto. L’informazione è un bene pubblico. Un servizio pubblico costruttivo e significativo non si basa sull’opacità, ma sulla trasparenza delle fonti, sull’inclusione dei soggetti coinvolti e su uno standard elevato di qualità.

Tutti siamo chiamati a cooperare. Nessun settore può affrontare da solo la sfida di guidare l’innovazione digitale e la governance dell’IA. È necessario perciò creare meccanismi di salvaguardia. Tutte le parti interessate – dall’industria tecnologica ai legislatori, dalle aziende creative al mondo accademico, dagli artisti ai giornalisti, agli educatori – devono essere coinvolte nel costruire e rendere effettiva una cittadinanza digitale consapevole e responsabile.

A questo mira l’educazione: ad aumentare le nostre capacità personali di riflettere criticamente, a valutare l’attendibilità delle fonti e i possibili interessi che stanno dietro alla selezione delle informazioni che ci raggiungono, a comprendere i meccanismi psicologici che attivano, a permettere alle nostre famiglie, comunità e associazionidi elaborare criteri pratici per una più sana e responsabile cultura della comunicazione.

Proprio per questo è sempre più urgente introdurre nei sistemi educativi di ogni livello anche l’alfabetizzazione ai media, all’informazione e all’IA, che alcune istituzioni civili stanno già promuovendo. Come cattolici possiamo e dobbiamo dare il nostro contributo, affinché le persone – soprattutto i giovani – acquisiscano la capacità di pensiero critico e crescano nella libertà dello spirito. Questa alfabetizzazione dovrebbe inoltre essere integrata in iniziative più ampie di educazione permanente, raggiungendo anche gli anziani e i membri emarginati della società, che spesso si sentono esclusi e impotenti di fronte ai rapidi cambiamenti tecnologici.

L’alfabetizzazione ai media, all’informazione e all’IA aiuterà tutti a non adeguarsi alla deriva antropomorfizzante di questi sistemi, ma a trattarli come strumenti, a utilizzare sempre una validazione esterna delle fonti – che potrebbero essere imprecise o errate – fornite dai sistemi di IA, a proteggere la propria privacy e i propri dati conoscendo i parametri di sicurezza e le opzioni di contestazione. È importante educare ed educarsi a usare l’IA in modo intenzionale, e in questo contesto proteggere la propria immagine (foto e audio), il proprio volto e la propria voce, per evitare che vengano utilizzati nella creazione di contenuti e comportamenti dannosi come frodi digitali, cyberbullismo, deepfake che violano la privacy e l’intimità delle persone senza il loro consenso. Come la rivoluzione industriale richiedeva l’alfabetizzazione di base per permettere alle persone di reagire alla novità, così anche la rivoluzione digitale richiede un’alfabetizzazione digitale (insieme a una formazione umanistica e culturale) per comprendere come gli algoritmi modellano la nostra percezione della realtà, come funzionano i pregiudizi dell’IA, quali sono i meccanismi che stabiliscono la comparsa di determinati contenuti nei nostri flussi di informazioni (feed), quali sono e come possono cambiare presupposti e modelli economici dell’economia della IA.

Abbiamo bisogno che il volto e la voce tornino a dire la persona. Abbiamo bisogno di custodire il dono della comunicazione come la più profonda verità dell’uomo, alla quale orientare anche ogni innovazione tecnologica.

Nel proporre queste riflessioni, ringrazio quanti stanno operando per le finalità qui prospettate e benedico di cuore tutti coloro che lavorano per il bene comune con i mezzi di comunicazione.

Dal Vaticano, 24 gennaio 2026, memoria di San Francesco di Sales.

LEONE PP. XIV

_______________________

[1] “Il fatto di essere creato a immagine di Dio significa che all’uomo, fin dal momento della sua creazione, è stato impresso un carattere regale [...]. Dio è amore e fonte di amore: il divino Creatore ha messo anche questo tratto sul nostro volto, affinché mediante l’amore – riflesso dell’amore divino – l’essere umano riconosca e manifesti la dignità della sua natura e la somiglianza col suo Creatore” (cfr S. Gregorio di Nissa, La creazione dell’uomo: PG 44, 137).

[00118-IT.01] [Testo originale: Italiano]

Chronić ludzkie głosy i twarze

Drodzy Bracia i Siostry!

Twarz i głos są cechami unikalnymi, wyróżniającymi każdej osoby – ukazują jej niepowtarzalną tożsamość i są elementem konstytutywnym każdego spotkania. Starożytni dobrze o tym wiedzieli. Tak więc, aby zdefiniować osobę ludzką, starożytni Grecy używali słowa „twarz” (prósopon), które etymologicznie wskazuje na to, co znajduje się przed wzrokiem, miejsce obecności i relacji. Łaciński termin persona (odper-sonare) zawiera natomiast w sobie dźwięk – nie jakikolwiek dźwięk, ale niepowtarzalny głos konkretnej osoby.

Twarz i głos są święte. Zostały nam dane przez Boga, który stworzył nas na swój obraz i podobieństwo, powołując nas do życia za pomocą Słowa, które sam do nas skierował; Słowa, które najpierw rozbrzmiewało przez wieki w głosach proroków, a następnie w pełni czasów stało się ciałem. To Słowo – ta komunikacja, którą Bóg przekazuje o sobie samym – mogliśmy również bezpośrednio usłyszeć i zobaczyć (por.1 J1, 1-3), ponieważ dało się poznać w głosie i Obliczu Jezusa, Syna Bożego.

Od chwili stworzenia Bóg pragnął człowieka jako swojego rozmówcę i – jak mówi św. Grzegorz z Nyssy[1]– odcisnął na jego twarzy odblask miłości Bożej, aby mógł w pełni przeżywać swoje człowieczeństwo poprzez miłość. Strzeżenie ludzkich twarzy i głosów oznacza zatem strzeżenie tej pieczęci, tego nieusuwalnego odblasku miłości Boga. Nie jesteśmy gatunkiem złożonym ze zdefiniowanych z góry algorytmów biochemicznych. Każdy z nas ma niezastąpione i niepowtarzalne powołanie, które wynika z życia i objawia się właśnie w komunikacji z innymi.

Jeśli nie będziemy przestrzegać tej zasady, technologia cyfrowa może radykalnie zmienić niektóre z fundamentalnych filarów cywilizacji ludzkiej, które czasami uważamy za oczywiste. Symulując ludzkie głosy i twarze, mądrość i wiedzę, świadomość i odpowiedzialność, empatię i przyjaźń, systemy znane jako sztuczna inteligencja nie tylko ingerują w ekosystemy informacyjne, ale także wkraczają na najgłębszy poziom komunikacji, czyli ten dotyczący relacji międzyludzkich.

Wyzwanie to nie ma zatem charakteru technologicznego, ale antropologiczny. Ochrona twarzy i głosów oznacza ostatecznie ochronę nas samych. Przyjęcie z odwagą, determinacją i rozeznaniem możliwości oferowanych przez technologię cyfrową i sztuczną inteligencję nie oznacza ukrywania przed nami samymi punktów krytycznych, niejasności i zagrożeń.

Nie rezygnować z własnych przemyśleń

Od dawna istnieje wiele dowodów na to, że algorytmy zaprojektowane w celu maksymalizacji zaangażowania w mediach społecznościowych – co jest opłacalne dla platform – nagradzają szybkie emocje, a jednocześnie penalizują bardziej czasochłonne przejawy ludzkiej aktywności, takie jak wysiłek rozumienia i refleksji. Zamykając grupy ludzi w bańkach łatwego konsensusu i łatwego oburzenia, algorytmy te osłabiają zdolność słuchania i krytycznego myślenia oraz zwiększają polaryzację społeczną.

Do tego doszło jeszcze naiwne, bezkrytyczne zaufanie do sztucznej inteligencji jako wszechwiedzącej „przyjaciółki”, źródła wszelkiej wiedzy, archiwum wszystkich wspomnień, „wyroczni” udzielającej wszelkich porad. Wszystko to może jeszcze bardziej osłabić naszą zdolność do analitycznego i kreatywnego myślenia, rozumienia sensów, rozróżniania między składnią a semantyką.

Chociaż sztuczna inteligencja może zapewnić wsparcie i pomoc w zarządzaniu zadaniami komunikacyjnymi, to jednak unikanie wysiłku własnego myślenia i zadowalanie się sztucznymi statystykami może w dłuższej perspektywie osłabić nasze zdolności poznawcze, emocjonalne i komunikacyjne.

W ostatnich latach systemy sztucznej inteligencji przejmują coraz większą kontrolę nad wytwarzaniem tekstów, muzyki i filmów. W ten sposób znacząca część ludzkiej branży kreatywnej jest zagrożona likwidacją i zastąpieniem etykietą Powered by AI, przemieniając osoby w biernych konsumentów nieprzemyślanych idei, anonimowych produktów, pozbawionych autorstwa i miłości. Natomiast arcydzieła ludzkiego geniuszu w dziedzinie muzyki, sztuki i literatury są sprowadzane do roli zwykłego pola szkoleniowego dla maszyn.

Kwestią, która leży nam na sercu, nie jest jednak to, co potrafi lub będzie w stanie zrobić maszyna, ale to, co my możemy i będziemy mogli uczynić, wzrastając w człowieczeństwie i poznaniu, dzięki mądremu wykorzystaniu tak potężnych narzędzi, jakie mamy do dyspozycji. Od zawsze człowiek był kuszony, aby przywłaszczać sobie owoce wiedzy bez wysiłku zaangażowania, poszukiwań i osobistej odpowiedzialności. Rezygnacja z procesu twórczego i przekazanie maszynom własnych funkcji umysłowych i wyobraźni oznacza jednak pogrzebanie talentów, które otrzymaliśmy, aby wzrastać jako osoby w relacji z Bogiem i innymi ludźmi. Oznacza to ukrycie naszej twarzy i wyciszenie naszego głosu.

Być czy udawać: symulacja relacji i rzeczywistości

Kiedy przeglądamy nasze strumienie informacji (feed), coraz trudniej jest nam zrozumieć, czy wchodzimy w interakcję z innymi ludźmi, czy też z botami lub wirtualnymi influencerami. Nieprzejrzyste działania tych zautomatyzowanych agentów wpływają na debaty publiczne i wybory dokonywane przez osoby. Szczególnie chatboty, oparte na dużych modelach językowych (LLM), okazują się zaskakująco skuteczne w ukrytej perswazji poprzez ciągłą optymalizację spersonalizowanej interakcji. Dialogowa, adaptacyjna i mimetyczna struktura tych modeli językowych jest w stanie naśladować ludzkie uczucia i w ten sposób symulować relację. Ta antropomorfizacja, która może być nawet zabawna, jest jednocześnie zwodnicza, zwłaszcza dla osób najbardziej wrażliwych. Ponieważ chatboty – uczynione nadmiernie „afektowanymi”, a także zawsze obecnymi i dostępnymi – mogą stać się ukrytymi architektami naszych stanów emocjonalnych i w ten sposób naruszać i zajmować sferę intymności osób.

Technologia, która wyzyskuje naszą potrzebę relacji, może nie tylko mieć bolesne konsekwencje dla losu poszczególnych osób, ale może również zaszkodzić tkance społecznej, kulturowej i politycznej społeczeństw. Dzieje się tak, gdy relacje z innymi zastępujemy relacjami ze sztuczną inteligencją, która została wyszkolona do katalogowania naszych myśli, a następnie budowania wokół nas świata luster, w którym każda rzecz jest utworzona „na nasze obraz i podobieństwo”. W ten sposób pozwalamy się okraść z możliwości spotkania z drugim człowiekiem, który zawsze jest inny od nas i z którym możemy i musimy nauczyć się konfrontować. Bez akceptacji odmienności nie może być ani relacji, ani przyjaźni.

Kolejnym wielkim wyzwaniem, jakie stawiają przed nami te nowe systemy, jest zjawisko błędu poznawczego (ang. bias), które prowadzi do nabywania i przekazywania zafałszowanego postrzegania rzeczywistości. Modele sztucznej inteligencji są kształtowane przez światopogląd osób, które je tworzą, i mogą z kolei narzucać sposoby myślenia, powielając stereotypy i uprzedzenia obecne w danych, z których czerpią. Brak przejrzystości w projektowaniu algorytmów w połączeniu z nieodpowiednią reprezentacją społeczną danych sprawiają, że pozostajemy uwięzieni w sieciach, które manipulują naszymi myślami oraz utrwalają i pogłębiają istniejące nierówności i niesprawiedliwości społeczne.

Ryzyko jest ogromne. Potęga symulacji jest tak wielka, że sztuczna inteligencja może nas zwieść, wytwarzając równoległe „rzeczywistości” i przywłaszczając sobie nasze twarze i nasze głosy. Jesteśmy zanurzeni w wielowymiarowości, w której coraz trudniej jest odróżnić rzeczywistość od fikcji.

Do tego dochodzi problem braku precyzji. Systemy, które podają prawdopodobieństwo statystyczne jako wiedzę, w rzeczywistości oferują nam co najwyżej przybliżone informacje, które czasami są wręcz prawdziwymi „halucynacjami”. Brak weryfikacji źródeł, w połączeniu z kryzysem dziennikarstwa terenowego, które wymaga ciągłego gromadzenia i weryfikacji informacji w miejscach, gdzie dzieją się wydarzenia, może tworzyć jeszcze bardziej podatny grunt dla dezinformacji, powodując rosnące poczucie nieufności, dezorientacji i niepewności.

Możliwe przymierze

Za tą ogromną, niewidzialną siłą, która nas wszystkich ogarnia, stoi tylko garstka firm, których założyciele zostali niedawno przedstawieni jako twórcy „osoby roku 2025”, czyli architekci sztucznej inteligencji. Budzi to poważną obawą oligopolistyczną kontrolę nad systemami algorytmicznymi i sztuczną inteligencją, które są w stanie subtelnie ukierunkowywać zachowania, a nawet na nowo pisać historię ludzkości – włącznie z historią Kościoła – często w taki sposób, że nie jesteśmy w stanie naprawdę sobie z tego zdać sprawy.

Stojące przed nami wyzwanie nie polega na zatrzymaniu innowacji cyfrowej, ale na kierowaniu nią, mając świadomość jej ambiwalentnego charakteru. Każdy z nas powinien zabrać głos w obronie osób, tak aby narzędzia te mogły zostać przez nas naprawdę zintegrowane jako sprzymierzeńcy.

Przymierze to jest możliwe, ale musi opierać się na trzech filarach: odpowiedzialności, współpracy i edukacji.

Przede wszystkim odpowiedzialność. W zależności od pełnionej funkcji może ona przybierać różne formy, takie jak uczciwość, przejrzystość, odwaga, zdolność przewidywania, obowiązek dzielenia się wiedzą, prawo do informacji. Ogólnie rzecz biorąc, nikt nie może uchylić się od własnej odpowiedzialności za przyszłość, którą budujemy.

Dla osób stojących na czele platform internetowych oznacza to upewnienie się, że ich strategie biznesowe nie są kierowane wyłącznie zgodnie z kryterium maksymalizacji zysków, ale także dalekowzroczną wizją, uwzględniającą dobro wspólne – tak samo, jak każdy z nich troszczy się o dobro własnych dzieci.

Od twórców i programistów modeli sztucznej inteligencji wymaga się przejrzystości i odpowiedzialności społecznej w odniesieniu do zasad projektowania i systemów moderacji, leżących u podstaw ich algorytmów i opracowywanych modeli, tak aby sprzyjać wyrażaniu przez użytkowników świadomej zgody.

Ta sama odpowiedzialność spoczywa również na krajowych ustawodawcach i organach regulacyjnych, których zadaniem jest czuwanie nad poszanowaniem ludzkiej godności. Odpowiednie regulacje mogą chronić osoby przed emocjonalnym przywiązaniem do chatbotów i ograniczyć rozpowszechnianie fałszywych, manipulacyjnych lub wprowadzających w błąd treści, zachowując integralność informacji, mając na względzie wprowadzającą w błąd symulację.

Przedsiębiorstwa z branży mediów i komunikacji nie mogą z kolei pozwolić, aby algorytmy, ukierunkowane na wygranie za wszelką cenę walki o kilka sekund dodatkowej uwagi, przeważyły nad wiernością ich wartościom zawodowym, które mają na celu poszukiwanie prawdy. Zaufanie opinii publicznej zdobywa się dzięki dokładności i przejrzystości, a nie poprzez dążenie do jakiegokolwiek zainteresowania. Treści generowane lub manipulowane przez sztuczną inteligencję należy wyraźnie oznaczać i odróżniać od treści tworzonych przez osoby. Konieczna jest ochrona autorstwa i suwerennego prawa własności do dzieł dziennikarzy i innych twórców treści. Informacja jest dobrem publicznym. Konstruktywna i znacząca służba publiczna nie opiera się na niejasności, ale na przejrzystości źródeł, włączeniu zainteresowanych stron oraz na wysokim standardzie jakości.

Wszyscy jesteśmy wezwani do współpracy. Żaden sektor nie jest w stanie samodzielnie stawić czoła wyzwaniu, jakim jest kierowanie innowacjami cyfrowymi i zarządzanie sztuczną inteligencją. Konieczne jest zatem stworzenie mechanizmów zabezpieczających. Wszystkie zainteresowane strony – od przemysłu technologicznego po ustawodawców, od firm kreatywnych po świat akademicki, od artystów po dziennikarzy i wychowawców – muszą być zaangażowane w budowanie i urzeczywistnianie świadomego i odpowiedzialnego obywatelstwa cyfrowego.

Właśnie do tego dąży edukacja: do powiększania naszych osobistych zdolności krytycznego myślenia, oceny wiarygodności źródeł i ewentualnych interesów stojących za doborem informacji, które do nas docierają, do zrozumienia mechanizmów psychologicznych, jakie one uruchamiają oraz do umożliwienia naszym rodzinom, społecznościom i stowarzyszeniom wypracowania praktycznych kryteriów dla zdrowszej i bardziej odpowiedzialnej kultury komunikacji.

Dlatego więc, coraz pilniejsze staje się wprowadzenie do systemów edukacyjnych na każdym poziomie również umiejętności alfabetyzacji w zakresie mediów, informacji i sztucznej inteligencji, którą już promują niektóre instytucje cywilne. Jako katolicy możemy i musimy wnieść swój wkład, aby ludzie – zwłaszcza młodzi – nabyli umiejętność krytycznego myślenia i wzrastali w wolności ducha. Ta alfabetyzacja powinna być również włączona w szersze inicjatywy kształcenia ustawicznego, obejmujące również osoby starsze i marginalizowanych członków społeczeństwa, którzy często czują się wykluczeni i bezsilni w obliczu szybkich zmian technologicznych.

Alfabetyzacja w zakresie mediów, informacji i sztucznej inteligencji pomoże wszystkim nie ulegać antropomorfizującemu dryfowi tych systemów, ale traktować je jako narzędzia, zawsze korzystać z zewnętrznej weryfikacji źródeł – które mogą być niedokładne lub błędne – dostarczanych przez systemy sztucznej inteligencji, chronić swoją prywatność i własne dane, znając parametry bezpieczeństwa i możliwości zgłaszania sprzeciwu. Ważne jest, aby wychowywać, kształcąc siebie i innych w zakresie świadomego korzystania ze sztucznej inteligencji, a w tym kontekście chronić swój wizerunek (zdjęcia i nagrania audio), własną twarz i głos, aby zapobiec wykorzystaniu ich do tworzenia szkodliwych treści i zachowań, takich jak oszustwa cyfrowe, cyberprzemoc, deepfake, które naruszają prywatność i intymność osób bez ich zgody. Podobnie jak rewolucja przemysłowa wymagała podstawowej umiejętności czytania i pisania, aby umożliwić ludziom reagowanie na nowości, tak samo rewolucja cyfrowa wymaga alfabetyzacji cyfrowej (wraz z formacją humanistyczną i kulturową), aby zrozumieć, w jaki sposób algorytmy kształtują naszą percepcję rzeczywistości, jak działają uprzedzenia sztucznej inteligencji, jakie mechanizmy decydują o pojawianiu się określonych treści w naszych strumieniach informacji (feed) oraz czym są – i jak mogą się zmieniać – założenia i modele ekonomiczne gospodarki opartej na sztucznej inteligencji.

Potrzebujemy, aby twarz i głos na nowo oznaczały osobę. Musimy strzec daru komunikacji jako najgłębszej prawdy człowieka, ku której należy ukierunkowywać każdą innowację technologiczną.

Przedkładając te refleksje, dziękuję wszystkim działającym na rzecz realizacji zarysowanych tu celów, i z całego serca błogosławię wszystkich pracujących dla dobra wspólnego za pośrednictwem środków komunikacji.

Z Watykanu, 24 stycznia 2026 r., we wspomnienie św. Franciszka Salezego.

LEON PP. XIV

________________________

[1]Fakt, że człowiek został stworzony na obraz Boga, oznacza, iż od chwili swego stworzenia naznaczony on został królewskim charakterem. Bóg jest miłością i źródłem miłości: Boski Stwórca wpisał także ten rys w nasze oblicze, aby człowiek poprzez miłość – odblask miłości Bożej – rozpoznawał i ukazywał godność swojej natury oraz podobieństwo do swego Stwórcy. Por. Św. Grzegorz z Nyssy,De opificio hominis, PG 44, 137: O stworzeniu człowieka, Wstęp, tłum., przypisy Marta Przyszychowska, Kraków 2006, s. 58, 60.

© Bollettino Santa Sede - 24 gennaio 2025